Recentemente uno dei nostri lettori ci ha chiesto suggerimenti su come ottimizzare il file robots.txt per migliorare la SEO.

Il file Robots.txt dice ai motori di ricerca come eseguire la scansione del tuo sito web, il che lo rende uno strumento SEO incredibilmente potente.

In questo articolo, ti mostreremo come creare un file robots.txt perfetto per la SEO.

Cos'è il file robots.txt?

Robots.txt è un file di testo che i proprietari di siti web possono creare per dire ai robot dei motori di ricerca come eseguire la scansione e indicizzare le pagine del loro sito.

In genere è memorizzato nella directory principale, nota anche come cartella principale, del tuo sito web. Il formato di base per un file robots.txt è simile al seguente:

User-agent: (user-agent name) Disallow: (URL string not to be crawled) User-agent: (user-agent name) Allow: (URL string to be crawled) Sitemap: (URL of your XML Sitemap)

Puoi avere più righe di istruzioni per consentire o non consentire URL specifici e aggiungere più Sitemap. Se non disabiliti un URL, i bot dei motori di ricerca presumono di essere autorizzati a eseguirne la scansione.

Ecco come può apparire un file di esempio robots.txt:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Sitemap: https://example.com/sitemap_index.xml

Nell'esempio robots.txt sopra, abbiamo consentito ai motori di ricerca di eseguire la scansione e indicizzare i file nella nostra cartella dei caricamenti di WordPress.

Successivamente, abbiamo impedito ai bot di ricerca di eseguire la scansione e l'indicizzazione dei plugin e delle cartelle di amministrazione di WordPress.

Infine, abbiamo fornito l'URL della nostra mappa del sito XML.

Hai bisogno di un file Robots.txt per il tuo sito WordPress?

Se non disponi di un file robots.txt, i motori di ricerca eseguiranno comunque la scansione e l'indicizzazione del tuo sito web. Tuttavia, non sarai in grado di indicare ai motori di ricerca quali pagine o cartelle non devono sottoporre a scansione.

Questo non avrà un grande impatto quando sarai il primo avviare un blog e non hanno molti contenuti.

Tuttavia, man mano che il tuo sito web cresce e hai molti contenuti, probabilmente vorrai avere un controllo migliore su come il tuo sito web viene scansionato e indicizzato.

Ecco perché.

I bot di ricerca hanno una quota di scansione per ogni sito web.

Ciò significa che eseguono la scansione di un certo numero di pagine durante una sessione di scansione. Se non completano la scansione di tutte le pagine del tuo sito, torneranno e riprenderanno la scansione nella sessione successiva.

Questo può rallentare la velocità di indicizzazione del tuo sito web.

Puoi risolvere questo problema impedendo ai robot di ricerca di tentare di eseguire la scansione di pagine non necessarie come le pagine di amministrazione di WordPress, i file dei plugin e la cartella dei temi.

Disabilitando le pagine non necessarie, salvi la quota di scansione. Ciò consente ai motori di ricerca di eseguire la scansione di ancora più pagine del tuo sito e indicizzarle il più rapidamente possibile.

Un altro buon motivo per utilizzare il file robots.txt è quando lo desideri impedire ai motori di ricerca di indicizzare un post o una pagina sul tuo sito web.

Non è il modo più sicuro per nascondere i contenuti al pubblico in generale, ma ti aiuterà a impedire che vengano visualizzati nei risultati di ricerca.

Che aspetto ha un file Robots.txt ideale?

Molti blog popolari utilizzano un file robots.txt molto semplice. Il loro contenuto può variare, a seconda delle esigenze del sito specifico:

User-agent: * Disallow: Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

Questo file robots.txt consente a tutti i bot di indicizzare tutti i contenuti e fornisce loro un collegamento al sito web Sitemap XML.

Per i siti WordPress, consigliamo le seguenti regole nel file robots.txt:

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /wp-admin/ Disallow: /readme.html Disallow: /refer/ Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

Questo dice ai robot di ricerca di indicizzare tutte le immagini e i file di WordPress. Non consente ai bot di ricerca di indicizzare i file dei plugin di WordPress, l'area di amministrazione di WordPress, il file readme di WordPress e i link di affiliazione.

Aggiungendo le Sitemap al file robots.txt, consenti ai bot di Google di trovare facilmente tutte le pagine del tuo sito.

Ora che sai che aspetto ha un file robots.txt ideale, diamo un'occhiata a come puoi creare un file robots.txt in WordPress.

Come creare un file Robots.txt in WordPress?

Esistono due modi per creare un file robots.txt in WordPress. Puoi scegliere il metodo che funziona meglio per te.

Metodo 1: modifica del file Robots.txt utilizzando All in One SEO

Tutto in uno SEO noto anche come AIOSEO è il miglior plugin SEO per WordPress nel mercato utilizzato da oltre 2 milioni di siti web.

È facile da usare e viene fornito con un generatore di file robots.txt.

Se non hai già installato il plugin AIOSEO, puoi vedere la nostra guida passo passo su come installare un plugin per WordPress.

Nota: Versione gratuita di AIOSEO è anche disponibile e ha questa caratteristica.

Una volta installato e attivato il plug-in, puoi utilizzarlo per creare e modificare il tuo file robots.txt direttamente dalla tua area di amministrazione di WordPress.

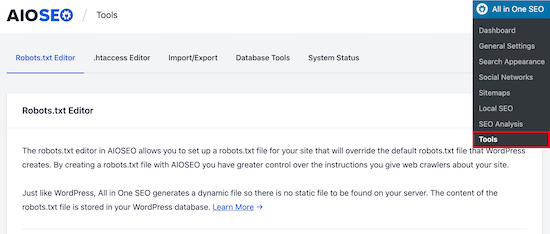

Vai semplicemente a Tutto in uno SEO »Strumenti per modificare il tuo file robots.txt.

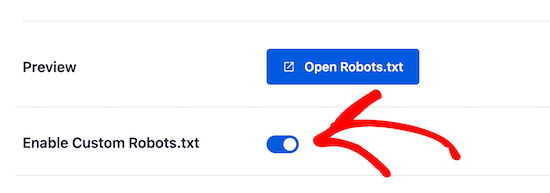

Innanzitutto, devi attivare l'opzione di modifica, facendo clic sul pulsante “Abilita file robots.txt personalizzato” che diventa blu.

Con questo interruttore, puoi creare un file robots.txt personalizzato in WordPress.

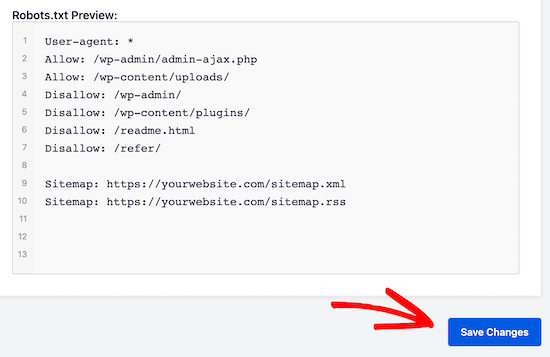

All in One SEO mostrerà il tuo file robots.txt esistente nella sezione “Anteprima Robots.txt” nella parte inferiore dello schermo.

Questa versione mostrerà le regole predefinite che sono state aggiunte da WordPress.

Queste regole predefinite indicano ai motori di ricerca di non eseguire la scansione dei file principali di WordPress, consentono ai bot di indicizzare tutto il contenuto e forniscono loro un collegamento alle Sitemap XML del tuo sito.

Ora puoi aggiungere le tue regole personalizzate per migliorare il tuo robots.txt per la SEO.

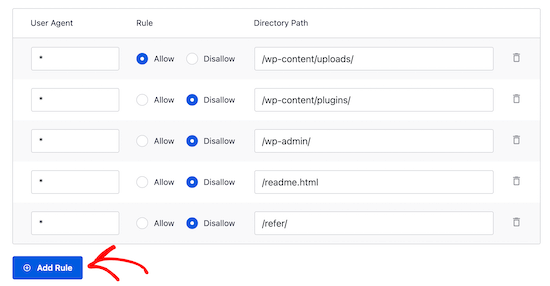

Per aggiungere una regola, inserisci un agente utente nel campo “Agente utente”. L'uso di un * applicherà la regola a tutti i programmi utente.

Quindi, seleziona se desideri “Consenti” o “Non consentire” ai motori di ricerca di eseguire la scansione.

Successivamente, inserisci il nome del file o il percorso della directory nel campo “Percorso directory”.

La regola verrà applicata automaticamente al tuo file robots.txt. Per aggiungere un'altra regola, fare clic sul pulsante “Aggiungi regola”.

Ti consigliamo di aggiungere regole finché non crei il formato robots.txt ideale che abbiamo condiviso sopra.

Le tue regole personalizzate avranno questo aspetto.

Al termine, non dimenticare di fare clic sul pulsante “Salva modifiche” per memorizzare le modifiche.

Metodo 2. Modifica manualmente il file Robots.txt utilizzando FTP

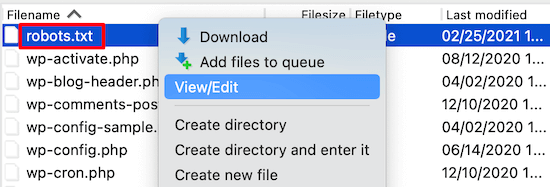

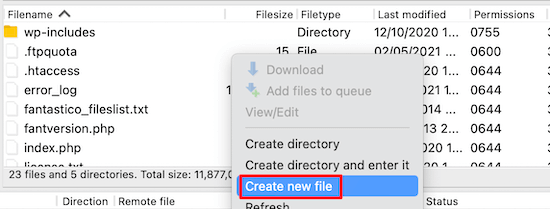

Per questo metodo, sarà necessario utilizzare un client FTP per modificare il file robots.txt.

Collegati semplicemente al tuo Hosting WordPress account utilizzando un client FTP.

Una volta dentro, sarai in grado di vedere il file robots.txt nella cartella principale del tuo sito web.

Se non ne vedi uno, probabilmente non hai un file robots.txt.

In tal caso, puoi semplicemente andare avanti e crearne uno.

Robots.txt è un file di testo semplice, il che significa che puoi scaricarlo sul tuo computer e modificarlo utilizzando qualsiasi editor di testo normale come Blocco note o TextEdit.

Dopo aver salvato le modifiche, puoi caricarle di nuovo nella cartella principale del tuo sito web.

Come testare il tuo file Robots.txt?

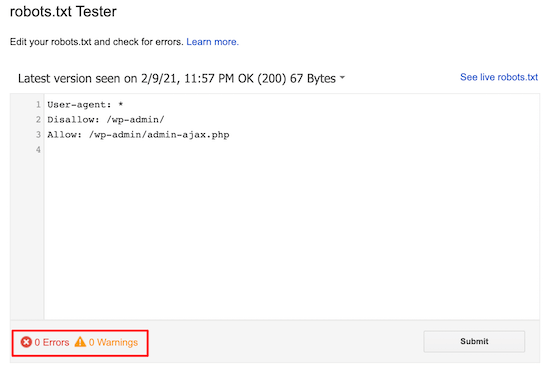

Dopo aver creato il file robots.txt, è sempre una buona idea testarlo utilizzando uno strumento di verifica dei file robots.txt.

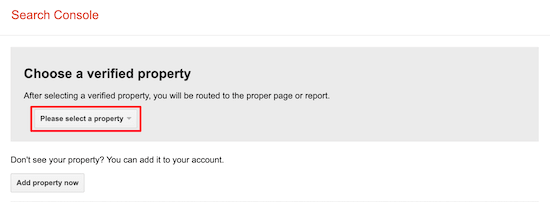

Esistono molti strumenti di prova per robots.txt, ma ti consigliamo di utilizzare quello interno Google Search Console.

Innanzitutto, devi collegare il tuo sito web a Google Search Console. Se non l'hai ancora fatto, consulta la nostra guida su come aggiungere il tuo sito WordPress a Google Search Console.

Quindi, puoi usare il file Strumento di test dei robot di Google Search Console.

Seleziona semplicemente la tua proprietà dall'elenco a discesa.

Lo strumento recupererà automaticamente il file robots.txt del tuo sito web ed evidenzierà gli errori e gli avvisi se ne trova.

Pensieri finali

L'obiettivo dell'ottimizzazione del file robots.txt è impedire ai motori di ricerca di eseguire la scansione di pagine non disponibili pubblicamente. Ad esempio, pagine nella tua cartella wp-plugins o pagine nella tua cartella admin di WordPress.

Un mito comune tra gli esperti di SEO è che il blocco di categorie, tag e pagine di archivio di WordPress migliorerà la velocità di scansione e si tradurrà in un'indicizzazione più rapida e in classifiche più elevate.

Questo non è vero. È anche contro le linee guida per i webmaster di Google.

Ti consigliamo di seguire il formato robots.txt di cui sopra per creare un file robots.txt per il tuo sito web.

Ci auguriamo che questo articolo ti abbia aiutato a imparare come ottimizzare il tuo file robots.txt di WordPress per la SEO. Potresti anche voler vedere il nostro guida SEO definitiva per WordPress e il i migliori strumenti SEO per WordPress per far crescere il tuo sito web.

Se ti è piaciuto questo articolo, iscriviti al nostro Canale Youtube per i tutorial video di WordPress. Puoi trovarci anche su Twitter e Facebook.

Il post Come ottimizzare il tuo WordPress Robots.txt per la SEO è apparso per primo WPBeginner.

Web Designer Freelancer Realizzazione Siti Web Serra Simone

Realizzo siti web, portali ed e-commerce con focus specifici sull’usabilità, l’impatto grafico, una facile gestione e soprattutto in grado di produrre conversioni visitatore-cliente. Elaboro siti internet, seguendo gli standard Web garantendo la massima compatibilità con tutti i devices. Sviluppo e-commerce personalizzati, multilingua, geolocalizzati per potervi mettere nelle migliori condizioni di vendita. Posiziono il tuo sito su Google per dare maggiore visibilità alla tua attività sui motori di ricerca con SEO di base o avanzato.